»Holo Harmonies«: Konzert und Ballett ergänzt um Extended Reality

Ein Live-Konzert und ein Live-Ballett an getrennten Orten, kombiniert mit XR-Animationen: So werden in Baden-Baden und Prag die »Holo Harmonies« in Szene gesetzt.

Technische Informationen zu »Holo Harmonies«

Während im Festspielhaus Baden-Baden der Elektromusiker Sven Helbig gemeinsam mit dem Stuttgarter Kammerorchester, dirigiert von Thomas Zehetmair, live spielen, erlebt das Publikum Hologramme der Tänzerinnen und Tänzer des Tschechischen Nationalballetts unter der Choreographie von Mauro Bigonzetti als live hinzugeschaltete Hologramm-Projektion. Umgekehrt erscheinen die Musikerinnen und Musiker des Stuttgarter Kammerorchesters als Hologramme in der Nationaloper Prag, während das Ballettensemble dort real performt.

Der Bühnenaufbau ist hierbei klar in zwei Hälften aufgetrennt, um zu verhindern, dass sich die realen und projizierten Künstlerinnen und Künstler überlagern.

An beiden Standorten wird von der Firma Musion Holotec, unter der Leitung von Robin Maass, ein technisches Setup aus halbtransparenter Gaze (11,5 m x 7,10 m) und lichtstarken Beamern installiert.

Kameras filmen die jeweils real vor Ort vorhandenen Künstlerinnen und Künstler — durch die vor dem Bühnengeschehen montierte Gaze. Dieses Live-Bild wird dann an den jeweils anderen Ort übertragen. Die jeweilig zugespielten Teile werden per Livestream verschickt. Dabei wird eine niedrige Latenz von 20 Millisekunden erreicht. Durch diese geringe Latenz werden die Performances vom Publikum als zeitgleich und synchron wahrgenommen.

Das projizierte Bild wird in Lebensgröße als Frontprojektion auf die halbtransparente Gaze projiziert.

Oberhalb der Köpfe der Performerinnen und Performer bietet die Gaze noch eine Fläche von rund 46 m2, die ausschließlich für die Projektion der begleitenden Animationen genutzt wird. Diese werden mittels eines 4K-Beamers projiziert und können in manchen Passagen der Aufführung auch die ganze Fläche der Gaze — rund 81 m2 — einnehmen und die Menschen auf der Bühne überlagern.

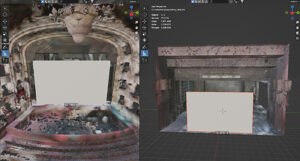

Prävisualisierung war essenziell

Wichtiger Bestandteil für die gesamte Kommunikation und Entwicklung über dieses außergewöhnliche Projektvorhaben war eine genaue Prävisualisierung.

Die Basis dafür schuf Benjamin Hopfmann, der Lidar-Scans der Locations anfertigte:

Das Festspielhaus Baden-Baden und die Nationaloper in Prag wurden damit exakt ausgemessen. Zum Einsatz kam hierbei ein 3D-Laserscanner von Faro mit 360°-3D-Kamera. Die damit generierten Punktwolken wurden von CG-Artist Felix Bucella als 3D-Geometrien aufbereitet.

In diesen 3D-Modellen der beiden Locations wurden dann zur Veranschaulichung der geplanten Arbeiten eine virtuelle Leinwand sowie Platzhalter für Orchester und Ballett eingerichtet, um so maßstabsgetreu technische Aspekte wie Projektionen, Licht- und Kameraaufbau planen zu können.

Entwicklung der animierten Visuals

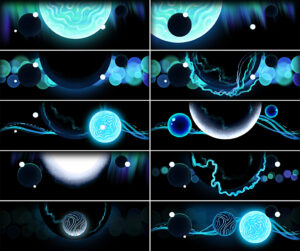

Die begleitenden, animierten Visuals von »Holo Harmonies« wurden über einen Zeitraum von rund sechs Monaten entwickelt und mittels 3D-Animationen zum Leben erweckt.

Die Basis hierfür war eine umfangreiche Bildrecherche der XR-Regisseurin Jana Günther. Diese wurde von Animations-Regisseur Moritz Mayerhofer durch Designs und Concept Art erweitert und zu einem visuellen Konzept entwickelt.

Herstellung der Animations-Assets

Für die Bildinhalte der Visuals wurden abstrakte Geometrien unter anderem mittels Geometry Nodes in der 3D-Software Blender hergestellt und zur weiteren Verarbeitung in die Realtime-Engine Unity übertragen. Dort wurden Lichtsetzung, Oberflächengestaltung sowie umfangreiche Partikeleffekte mittels VFX-Graph umgesetzt.

Verantwortlich dafür zeichnet der CG-Artist Henning Schild, der im Rahmen der Projektentwicklung viele kreative Ansätze entwickelte und modular nutzbare Assets produzierte. Diese dienten als digitaler Katalog zur weiteren Nutzung.

Lead-Developer und Technical Artist Felix Lange entwickelte für die Produktion verschiedene Tools, mit denen nicht nur die Handhabung der langen Szenen (bis zu 16 Minuten) erleichtert wurde, sondern auch grafische Funktionen wie etwa das Zerfallen von Oberflächen in einer komplexen Verbindung von Shader-Programmierung, VFX-Graph und physikalischen Funktionen.

Durch die Nutzung eines cloud-basierten Versionsverwaltungs-Tools wurde eine Arbeitsumgebung eingerichtet, in der mehrere Artists standortunabhängig und gleichzeitig am Projekt arbeiten konnten.

Realtime

Ein Argument für die Nutzung einer Realtime-Engine war unter anderem die Möglichkeit, auf reale Einflüsse der Orchester-Performance, wie etwa Tempo-Veränderungen einzugehen, um so audioreaktive Inhalte in die Visuals einfließen zu lassen.

Ein weiterer Vorteil waren die verhältnismäßig geringen Datenmengen, die bei einer herkömmlichen Animationsfilm-Produktion allein schon aufgrund der Programmdauer mehrere hundert Gigabyte beansprucht hätten.

Durch das Involvement verschiedener Gewerke bis hinein in die Phase der Postproduktion erhielt der Aspekt der Flexibilität eine starke Gewichtung.

Keinen Produktionsbericht mehr verpassen und einfach den Newsletter abonnieren:

Seite 1: Einleitung, Konzept, künstlerisch Beteiligte

Seite 2: Infos zur Technik und den Grafikanimationen