Videoschnitt in der Live-Produktion – neu gedacht

Die BBC präsentierte auf dem AWS-Stand die neueste Version des innovativen Open-Source-Projekts »Time Addressable Media Store« (TAMS). Jens Gnad von Logic erläutert, wie das Ganze funktioniert.

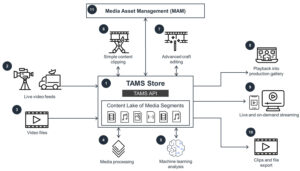

Dieses Architekturdiagramm zeigt das Konzept, wie ein Time Addressable Media Store (TAMS) im Mittelpunkt eines schnellen Workflows zur Verarbeitung von Live- oder Near-Live-Video- und Audioinhalten steht.

Jens Gnad von Logic Media Solutions erläutert das TAMS-Konzept.

Die TAMS- Initiative, die bereits auf der IBC vorgestellt wurde, denkt den Ansatz des Videoschnittverfahrens komplett neu.

Im Gegensatz zu traditionellen Methoden, die auf dedizierte, hochperformante Speichersysteme für Growing Files angewiesen sind, arbeitet TAMS mit einem völlig anderen Konzept: Live-Videosignale werden nicht als anwachsende Dateien, sondern als einzelne »Chunks« gespeichert – ähnlich dem HLS-Verfahren (HTTP Live Streaming).

Diese Chunks können in ihrer Länge variieren – von einzelnen Frames bis hin zu den auf der Messe demonstrierten den auf der Messe demonstrierten Chunks mit einer Länge von zwei Sekunden. Sobald ein Chunk fertiggestellt ist, wird er abgelegt und steht sofort für die Verarbeitung durch angeschlossene Systeme zur Verfügung – sei es ein Videomischer, Player oder Schnittsystem.

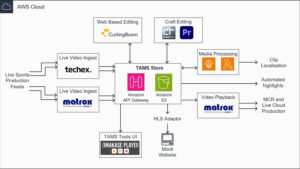

Der besondere Vorteil dieses Ansatzes liegt darin, dass jede Datei nur einmal existieren muss. Nach der einmaligen Erstellung kann mit jedem TAMS-kompatiblen Gerät darauf zugegriffen werden. Mittlerweile gibt es bereits Cloud-Native-Editoren und Videoschnittsysteme, die nativ mit diesem Format arbeiten können, sowie Videomischer von AWS-Partnerunternehmen und einen neuen Open-Source-Player für die sofortige Wiedergabe.

Die Besonderheit dieses Ansatzes besteht darin, dass TAMS den Videoschnitt auf objektbasierten Speichern wie AWS S3 ermöglicht – sowohl in der Cloud als auch on-premises. Dies eliminiert den Bedarf an teuren, hochperformanten Spezialservern und macht den Videoschnitt deutlich flexibler und kostengünstiger.

Das Projekt ist auf GitHub verfügbar und kann dort heruntergeladen werden.