Adobe MAX 2023

Adobe präsentiert die Zukunft von Kreativität und KI — bei der Adobe MAX, die vom 10. bis zum 12. Oktober 2023 in Los Angeles, aber auch online stattfindet.

Adobe-CEO Shantanu Narayen eröffnete Adobe MAX mit einer Keynote, in deren Fokus künstliche Intelligenz stand. Kreativität sei ein wichtiger Treiber der Wirtschaft. »Digital« transformiere unser Leben, und KI beschleunige diesen Schritt und mache uns noch produktiver, so Narayen.

Er betonte, dass man bei jeder Adobe MAX nach vorne blicke und immer interessante neue Funktionen vorstelle wie etwa Enhance Speech bei Premiere Pro (IBC-Meldung). Manche Funktionen, die man üblicherweise bei einer Adobe MAX vorstelle, hätten allerdings ursprünglich gar nicht auf der Roadmap gestanden und sich letztlich im Entwicklungsprozess herauskristallisiert.

Dazu dürften auch die Entwicklungen um die generative KI Firefly zählen, die nun innerhalb weniger Monate stark Fahrt aufgenommen haben.

Adobe sei der Meinung, dass generative Technologien die Kreativität der Anwender unterstützen sollten. Deshalb werde man viele Firefly-Features auch in andere Produkte im Adobe-Kosmos einbringen, und zwar künftig immer mit Content Credentials per Default (IBC-Meldung).

Am Ende der Keynote betone CEO Shantanu Narayen, dass er fest daran glaube, dass menschliche Kreativität niemals durch KI ersetzt werden könne.

David Wadhwani, President von Digital Media bei Adobe, ging im Anschluss näher auf den Bereich KI ein. Er sagt: »Seit der Veröffentlichung unseres ersten Firefly-Modells im März waren wir von der erstaunlichen Reaktion der Community überrascht. Uns wurde bewusst, wie hilfreich Firefly für die Verbesserung von experimentellen Designs und beschleunigten Workflows ist – und das, ohne die kreative Kontrolle zu beeinträchtigen«, so Wadhwani. »Mit über 3 Milliarden generierten Bildern, davon mehr als eine Milliarde allein im letzten Monat, zeigt die schnelle Akzeptanz von Firefly die unglaubliche Leistungsfähigkeit der Einbindung von Basismodellen in die Workflows, die die Nutzerinnen und Nutzer kennen und lieben.«

Er betonte, dass Firefly optimiert wurde für die Integration in alle Adobe-Tools, kommerziell sicher sei, dass transparent sei, mit welchen Daten die KI gelernt habe und dass damit Content Credentials unterstützt würden.

Was derzeit mit Firefly stattfinde, erinnere ihn an die ersten Tage von Photoshop. Auch damals habe es viele Skeptiker gegeben, die der Meinung waren, dass sich damit ihre Jobs erledigt hätten. Aber genau das Gegenteil sei passiert, die Produktivität sei enorm gestiegen, so Wadhwani. Er ergänzte: »KI wird nicht mehr verschwinden.«

Kreative könnten mit KI schneller und effizienter arbeiten und den Hunger nach Content besser stillen. Wadhwani kündigte drei neue Firefly-Modelle an: Firefly Image 2 Model, Firefly Vector Model und Firefly Design Model. Sie wurden für die Erstellung von Inhalten entwickelt, die für die kommerzielle Nutzung sicher sind.

Firefly Image 2 ist das Bildbearbeitungsmodell der nächsten Generation, das Nutzerinnen und Nutzern ein neues Maß an kreativer Kontrolle und Qualität bietet. Firefly Image 2 erzeuge hochwertigere Bilder, rendere Personen genauer und verbessere die Textausrichtung. Firefly Vector Model sei das weltweit erste generative KI-Modell, das sich auf die Erstellung von Vektorgrafiken konzentriere. Mit der Funktion Text-to-Vector-Graphic bringe es das Know-how von Adobe in Hinblick auf Vektorgrafiken und generative KI direkt in Adobe-Illustrator-Workflows ein – für die Erstellung von Logos, Website-Grafiken, Produktverpackungen, Icons und mehr. Das neue Firefly Design Model ermögliche mit der neuen Funktion Text-to-Template die sofortige Erstellung von hochwertigen Vorlagen wie Flyern, Postern oder Einladungen direkt in Express.

Ashley Still, SVP & GM, Creative Product Group von Adobe, ging in ihrem Vortrag im Detail auf die angesprochenen Firefly-Neuheiten innerhalb der Adobe Produktpalette ein.

Es wurden zudem mehr als 100 neue KI-Funktionen und Updates für alle Creative-Cloud-Flaggschiff-Applikationen veröffentlicht, darunter Adobe Illustrator, Adobe Photoshop, Adobe Lightroom, Adobe Premiere Pro, Adobe After Effects und Adobe Stock, so Ashley Still.

Photoshop: Hier ist »Generative Fill« the next big thing, das sei schon jetzt eine der Funktionen, die in Photoshop am häufigsten eingesetzt würden.

Anna Naught, Sr. Design Evangelist, findet gar, dass Generative Fill einer der eindrucksvollsten neuen Funktionen der vergangenen Jahre sei. Ebenso überzeugend sei auch »Generative expand«, um Bilder zu erweitern. Das verändere auch die Art, in Photoshop zu arbeiten. Es bleibe mehr Zeit für kreatives Arbeiten, so Naught.

Im weiteren Verlauf ging Ashley Still auf Lightroom ein. Zu den KI-gestützten Weiterentwicklungen in Lightroom gehören Lens Blur, HDR-Optimierung, Point Color sowie ein neues, optimiertes Bearbeitungserlebnis in Lightroom Mobile.

Illustrator: Auch hier ist generative KI integriert. Mit dem Firefly Vector Modell ist es nun möglich, per »Text-to-Vector Graphic« per KI vektorisierte Grafiken zu generieren. Zusätzlich gibt es Mockup, Retype und Updates für Share for Review, sowie das neue Illustrator im Web. »We can’t wait to see what you create« sagte Ashley Still hierzu.

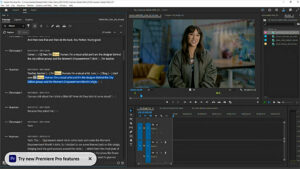

Dacia Saenz, Sr. Quality Engineer and Animation Explorer von Adobe, zeigte neue Funktionen in Premiere Pro. Sie konzentrierte sich auf neue KI-gestützte, textbasierte Bearbeitungs- und Bewegungsverbesserungen in Premiere Pro und After Effects, die nahtlose Veröffentlichung von Videoinhalten auf TikTok, YouTube und Facebook Premiere Pro erlauben. Die Funktionen »Text-to-Edit« und »Enhance-Speech« standen hierbei im Fokus.

Auch auf Frame.io ging Ashley Still noch kurz ein und erläuterte, dass die Review-Plattform nun auch mit PDFs und anderen Dateitypen arbeiten könne.

Adobe Express Neuerungen

Scott Belsky, Chief Strategy Officer and EVP, Design & Emerging Products von Adobe, ging in seinem Part insbesondere auf die neue Software »Adobe Express« ein. Es sei ein sehr starkes Tool, das leicht zu bedienen und letztlich ein Werkzeug für »alles« sei — und das eben auch viele Firefly-Funktionen biete.

Paul Trani und Katrina Torrijos zeigten die Leistungsfähigkeit der Software in ihren Demos.

Express-Anwender und Anwenderinnen können jetzt generative Füllung verwenden, um Objekte oder Personen ganz einfach mit einer kurzen Beschreibung in jedes Bild einzufügen, zu entfernen oder zu ersetzen. Die neuen generativen KI-Fähigkeiten von Text to Template, die auf dem neuen Firefly Design Model aufbauen, geben Nutzerinnen und Nutzern die Möglichkeit, editierbare Vorlagen mit nur einer Textbeschreibung zu erstellen.

Die Funktion Translate erspart die zeitaufwändige Lokalisierung von Inhalten und bietet eine Auswahl von 45 Sprachen. Die neuen Zeichen- und Malfunktionen, Drawing und Painting, bieten über 50 mehrfarbige Farb- und Dekorationspinsel, die Holzkohle-, Bleistift- und Aquarelltexturen imitieren.

Adobe GenStudio & Experience Manager

Adobe stellt außerdem Adobe GenStudio vor, eine neue End-to-End-Lösung, die Anwendungen aus Creative Cloud, Express und Experience Cloud zusammenführt. Auch dabei steht die generative KI Firefly im Mittelpunkt, um Marken dabei zu unterstützen, die steigende Content-Nachfrage erfüllen zu können.

Adobe stellt auch eine Anpassung der Firefly-Modelle sowie neue APIs vor, die sicherstellen, dass Unternehmensinhalte über Marketing- und Kreativ-Workflows hinweg markenkonform und skalierbar sind. Durch die Optimierung von Content Supply Chains – dem Prozess der Produktion und Bereitstellung von Inhalten, die zu eindrucksvollen Kundenerlebnissen führen – können Marken jetzt ihr Geschäftswachstum mit der Skalierung von Personalisierungsmaßnahmen vorantreiben und so die Kundenbindung und -loyalität maximieren.

Zudem bietet Adobe mit dem neuen Adobe Experience Manager Sites neue Funktionen an, die es Unternehmen ermöglichen, Web-Inhalte schnell zu testen und zu optimieren. So können Unternehmen die Konversionsrate erhöhen und herausragende Website-Geschwindigkeiten mit den von Adobe entwickelten Performance-Tools erzielen – einschließlich optimiertem Boiler-Plate-Code, phasenweisem Seiten-Rendering, persistenter Zwischenspeicherung und kontinuierlichem Real-User-Monitoring.

Am Ende der Veranstaltung kündigte David Wadhwani noch Image-2-Modell an, das bessere Qualität und mehr Kontrolle bietet. Kelly Hurlburt demonstrierte dessen Fähigkeiten und zeigte unter anderem, wie man eigene Vorlagen hochladen und deren Stil auf KI-Bilder übertragen kann.

David Wadhwani bilanzierte: »We are just getting started«. Adobe biete schon jetzt die beste integrierte Lösung über verschiedene Apps und Programme hinweg. Es sollen aber noch viele mehr kommen. Dabei ist die Rede von Funktionen wie »Text to video«, »Image to video« und auch »Train your own model«.