Next Generation: Wandel in der Aufnahmetechnik

Aktuelle Aufnahmetechnik, das sind Single-Sensor-Kameras und DSLRs, das sind Codecs, Files und Speicherkarten. Welche aktuellen Techniktrends sind virulent, was zeichnet sich jetzt schon für die Zukunft ab, worauf sollte man bei der Auswahl ein Auge werfen? Wie wird der Trend zu Stereo-3D sich in der Aufnahmetechnik auswirken?

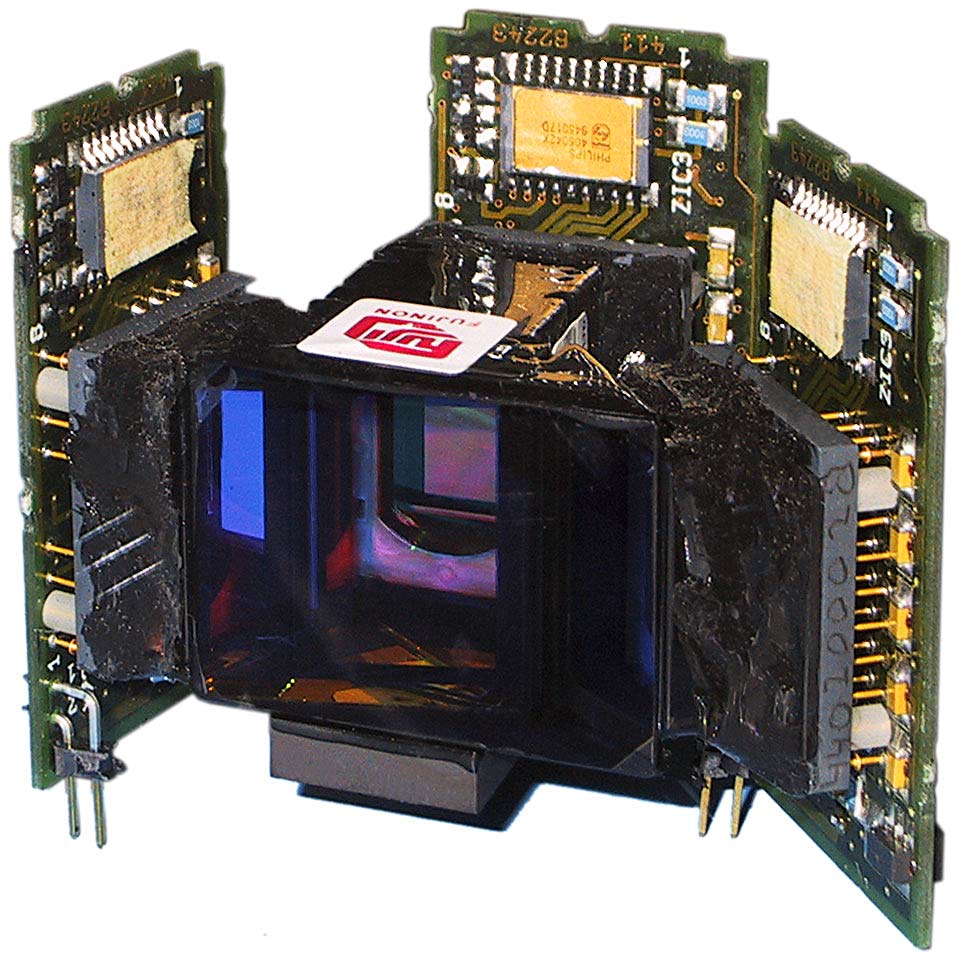

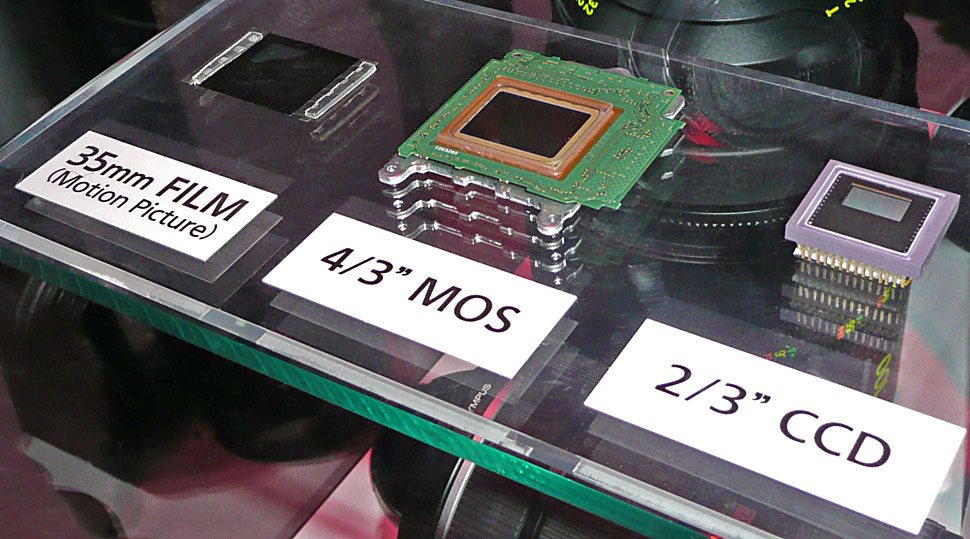

Es gibt immer noch Camcorder, die aussehen und in groben Zügen auch so funktionieren, wie das im Profi-Videobereich für viele Jahre der Normalfall war: Drei Bildsensoren sind an einem Prisma befestigt, es wird ein roter, grüner und blauer Bildauszug hergestellt. Diese drei Bildteile werden dann gewichtet, zu einem gemeinsamen Signal kombiniert und gespeichert. Die Mehrzahl der im Fernsehbereich eingesetzten Camcorder funktioniert nach diesem Prinzip. Und es werden aus gutem Grund auch weiterhin neue Modelle entwickelt und verkauft, die nach diesem Konzept konstruiert sind.

Dabei gibt es einige klare Technologietrends: Bei den Sensoren sind CMOS-Bildwandler angesagt, die Bilddiagonalen werden immer kleiner, tendieren zum Drittelzoll und weniger, als Speichermedium werden immer öfter Speicherkarten eingesetzt. Das ist der Mainstream, der mittlerweile sowohl für den schnellen Reportagedreh, wie auch für Dokus und für Soaps eingesetzt wird.

Daneben blüht aber eine Vielfalt, wie man sie bisher nicht kannte. Eine der Triebfedern dafür ist der Wunsch, sich vom klassischen Videolook zu lösen, den die traditionelle Bauweise mit drei Sensoren und Prisma befördert: Die hohe Schärfentiefe dieser Kameras wird teilweise als unnatürlich, als klischeehafter Look und als gestalterische Einschränkung empfunden. Viele weitere Gründe werden angeführt — aber manchmal ist es auch einfach der simple Wunsch nach etwas Neuem, der dahinter steckt, wenn die Anwender andere Werkzeuge ausprobieren.

So hat sich ein Bereich entwickelt, der im Vergleich zum Mainstream mengenmäßig immer noch klein, aber sehr lautstark und umtriebig ist: Single-Sensor-Kameras mit nur einem Bildwandler, der aber in etwa die Abmessungen eines 35-mm-Kamerabildfensters hat. Der amerikanische Hersteller Red hat diesen Kameratyp keineswegs erfunden, aber er hat ihn populär und bekannt gemacht — und er hat die Preise dafür nach unten gedrückt.

Hersteller wie Arri und Sony bauten und bauen digitale Kameras in dieser Art für das High-End, nach und nach sinkt diese Technik aber bei diesen und anderen Herstellern auch in niedrigere Preisregionen. Panasonic und Sony etwa kündigten in den vergangenen Monaten in kurzer Folge Single-Sensor-Geräte an, die von der Bauform an klassische Handhelds erinnern, aber als Large-Single-Sensor-Geräte ausgeführt sind — zwar nicht mit Sensoren in 35-mm-Größe, aber immerhin mit größeren Bilddiagonalen aus dem oberen Digitalfotosegment.

Damit ist ein anderer Bereich angesprochen: DSLRs, also digitale Spiegelreflexkameras. Ganz und gar nicht für den schnellen Reportagedreh geeignet und eigentlich auch gar nicht schwerpunktmäßig für die Videoproduktion konzipiert, werden diese Kameras mittlerweile gern für szenische Produktionen — meist mit geringem Budget — erfolgreich eingesetzt. Hauptgrund dafür ist die filmähnliche Schärfentiefe dieser Geräte — bei vergleichsweise niedrigem Preis, geringer Baugröße und Wechselobjektivanschluss. Interessant sind auch neuerdings verfügbare Modifikationen von DSLRs, die von verschiedenen Firmen, etwa von FGV Schmidle, angeboten werden: Dabei werden meist andere Lens-Mounts eingebaut, die mehr Stabilität mitbringen und/oder den direkten Anschluss von Filmobjektiven erlauben.

Es geht: Man kann nicht nur mit den klassischen Werkzeugen Filme produzieren, sondern auch mit anderen Konzepten. Es ist aber nicht unbedingt leichter: Wer unter strengem Sparzwang eine preisgünstige Single-Sensor-Kamera mit großem Sensor aber sehr kleinem Display einsetzt, der wünscht sich nach der Sichtung zahlloser unscharfer Takes vielleicht doch, er hätte mit einer Mainstream-Kamera mit größerer Schärfentiefe gedreht…

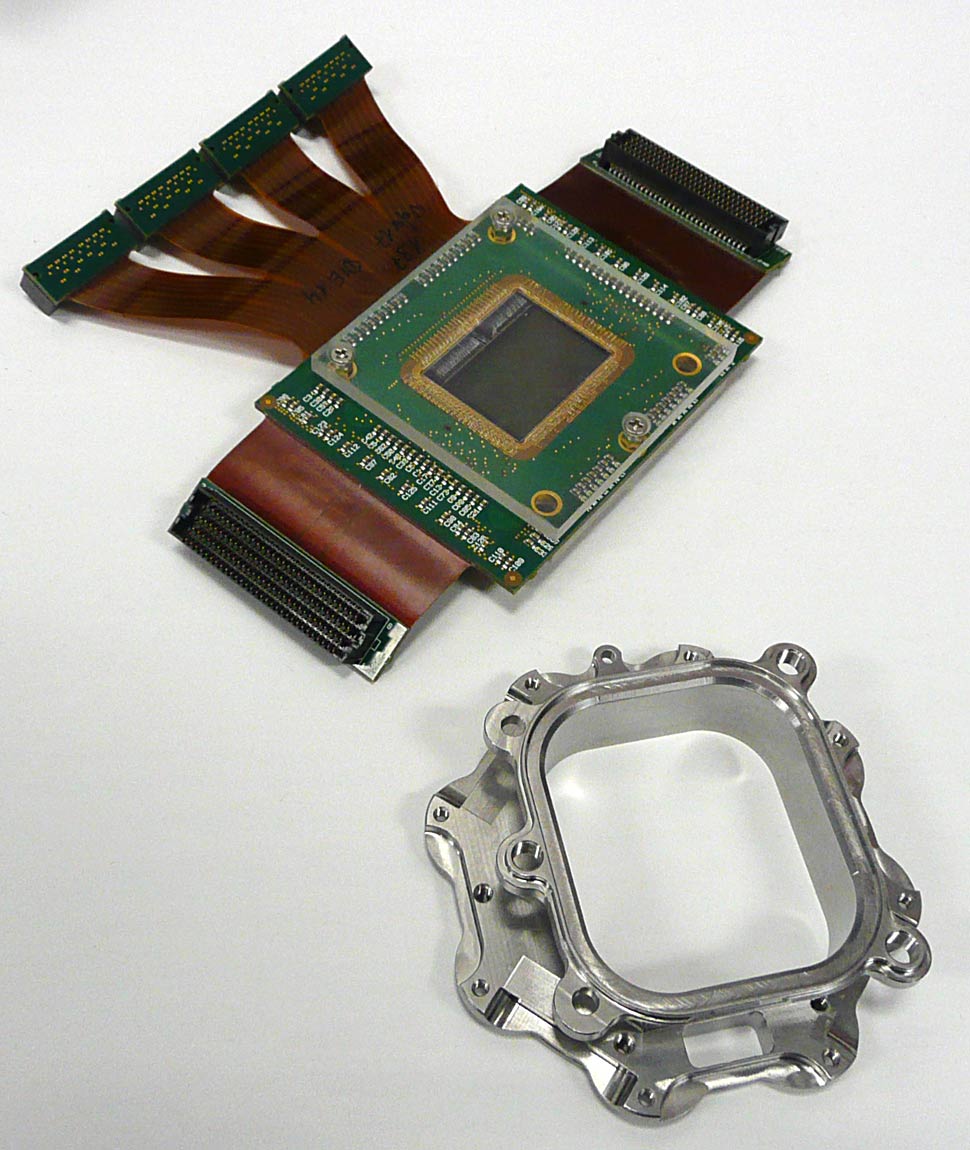

Das Drehen auf Film ist ein schrumpfender Markt, manche Bereiche des Filmgeschäfts sind schon heute tot. Weil es aber besonders in Deutschland viel 16-mm-Equipment im Markt gibt, arbeiten P+S Technik und Easylook an miteinander konkurrierenden Systemen, mit denen sich 16-mm-Kameras auf Digitalbetrieb umrüsten lassen: Statt des Filmmagazins wird dabei ein »digitales Magazin« an die Filmkamera angeflanscht, das einen Sensor und ein digitales Speichermodul beinhaltet (P+S-Infos, Easylook-Infos). So kann 16-mm-Equipment weiter genutzt werden, mit dem ja in Deutschland bis dato die meisten TV-Vorzeigeproduktionen realisiert wurden — das kann wirtschaftlicher sein, als alles neu zu kaufen. Mit dem Trend zum großen Sensor ist diese Entwicklung aber nicht in Einklang zu bringen: Es steht eben nur das 16-mm-Bildfenster zur Verfügung.

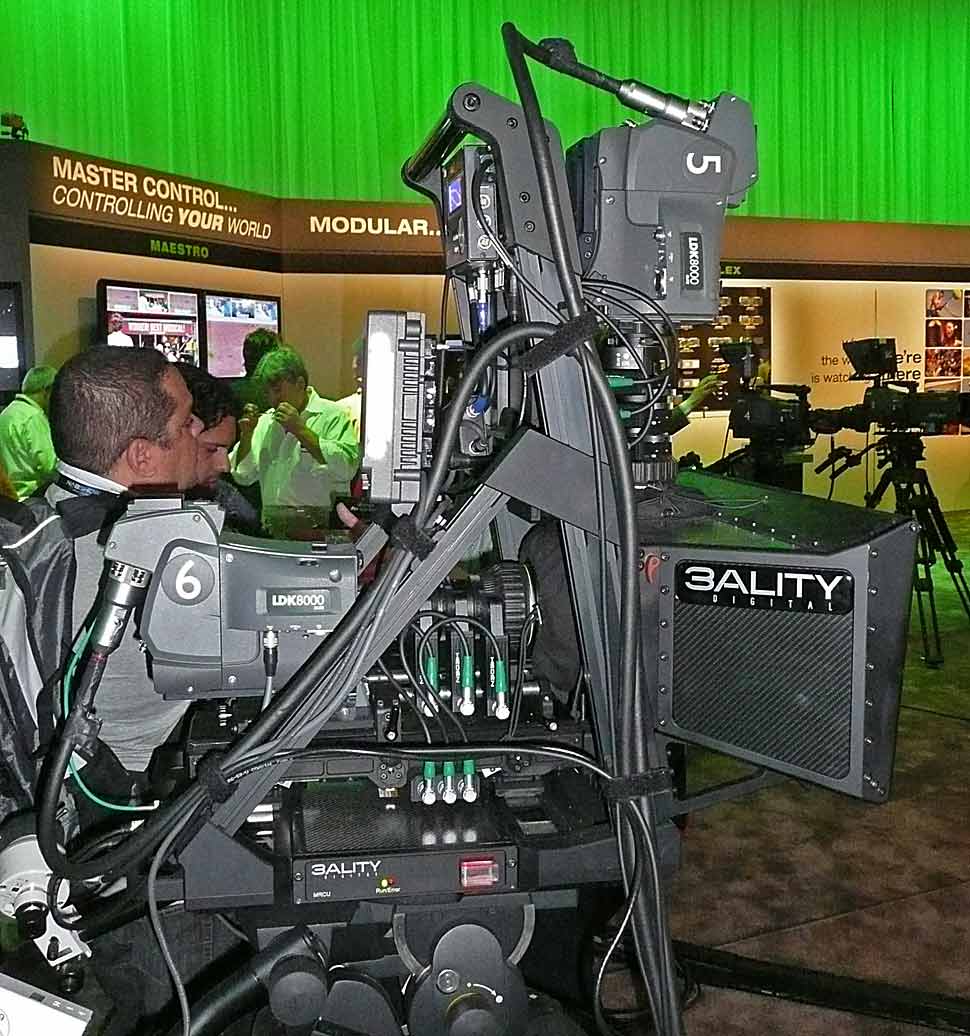

Stereo-3D

Ein wahrer Hype, mit großem Werbedruck im Consumer-Bereich, ist um das Thema Stereo-3D entstanden. Derzeit wird dieser Bereich in der Aufnahmetechnik überwiegend so erschlagen, dass man zwei separate Kameras für die Aufnahme verwendet, die entweder nebeneinander oder auf einem Spiegel-Rig montiert und zur Steuerung und Veränderung der Bildwirkung mechanisch bewegt werden. In der Signalverarbeitung werden dann verschiedene Prozessoren eingesetzt, um die Bilder zu verknüpfen und die stereoskopische Bildwirkung zu kontrollieren und zu korrigieren. Trotz aller Verbesserungen, die hier bisher schon erreicht wurden: Das ist sehr viel umständlicher und aufwändiger als eine 2D-Produktion. Es zeichnet sich also eine klare Entwicklungslinie ab: Single-Piece-3D-Camcorder für die Aufnahme und die Verlagerung der Bildjustage in den digitalen Bereich.

Neben einigen kleinen Herstellern ist momentan nur Panasonic so weit, im Profibereich einen Single-Piece-3D-Camcorder anzubieten (Infos, Video, Test). Sollte das Thema Stereo-3D tatsächlich abheben — was noch keinesfalls sicher ist — und sich dadurch ein nennenswertes Marktvolumen für die Kamerahersteller abzeichnen, dann werden andere Anbieter rasch nachziehen: So hat etwa Sony schon im Herbst 2009 den Prototypen einer Single-Lens-3D-Kamera gezeigt (Meldung) — und in den Laboren der anderen wird ebenfalls daran gebastelt.

Objektive

Das Aufkommen von HD erfordert nicht nur neue Elektronik, sondern auch eine Aufrüstung bei den Optiken. Selbst sehr hochwertige SD-Objektive wurden von den Herstellern so ausgelegt, dass die Abbildungsleistung oberhalb der in PAL maximal möglichen Auflösung rasch abfällt. Nutzt man diese Objektive im HD-Umfeld weiter, beschneidet man schon ganz am Anfang der Produktionskette die Auflösung/Bildschärfe und verschenkt einen Großteil des Zugewinns an Bildqualität, den HD prinzipiell ermöglicht.

Während die Preise bei HD-Camcordern sehr rasch auf das Niveau von SD-Geräten abgesunken sind und es teilweise sogar unterschritten haben, entwickelten sich die Preise bei den Objektiven zunächst nicht parallel dazu: Hochwertige HD-Objektive erfordern teureres Ausgangsmaterial und höheren Produktionsaufwand.

So hat sich — besonders am unteren Ende der Profi-Produktpalette — die Schere zwischen Camcorder und Objektiv geöffnet: Viele preisgünstige Camcorder werden derzeit im Paket mit Objektiven angeboten, deren Qualität nicht ausreicht, um die Möglichkeiten der Kameraelektronik auszuschöpfen. Weil aber die Kunden andererseits auch nicht bereit sind, für ein Objektiv das Vielfache des Kamerapreises auszugeben, wurden hierfür Lösungen gesucht und gefunden.

Ein gängiger Weg besteht darin, dass man bei den Abbildungsleistungen der Objektive Kompromisse eingeht und diese dann auf digitalem Weg in der Kamera kompensiert: In der Kamera sind Korrekturwerte abgelegt, mit denen sich die systemimmanenten Linsenfehler der jeweiligen Objektivbaureihe korrigieren lassen. So lassen sich etwa Farbsäume an Objektkanten, deren Ursache <LEX>chromatische Aberration</LEX> ist — aber auch andere Abbildungsfehler — elektronisch minimieren. Das ist jedoch immer nur die zweitbeste Methode: Qualitativ besser wäre es, wenn das Objektiv ein Bild ohne diese Abbildungsfehler auf die Sensoren bringen würde.

Für die Zukunft sind hier — wegen des immer weiter steigenden Kostendrucks — auch im Profibereich Entwicklungen zu erwarten, die im Fotobereich bei Geräten mit fest installiertem Objektiv schon gang und gäbe sind: Es werden sehr einfache, preisgünstige, aus Profisicht sogar schon minderwertige Linsensysteme verwendet und deren massive Abbildungsfehler werden, soweit das möglich ist, in der Signalverarbeitung der Kamera auf digitalem Weg kompensiert. Die Methoden hierfür sind mittlerweile recht raffiniert und das Ganze funktioniert sogar abhängig von der Brennweiteneinstellung: Kantenverzerrungen entstehen eben überwiegend im WW-Bereich und müssen dann auch nur dort korrigiert werden.

Spinnt man diesen Gedanken weiter, könnte es irgendwann auch so etwas wie »Raw-Objektive« geben: Linsensysteme ohne Vergütung und Beschichtungen, deren Farbfehler, Verzerrungen und Verzeichnungen dann in der Kamera digital ausgeglichen werden. Also nicht nur CAC und ALAC, wie Panasonic und Sony die Funktionen für die digitale Kompensation chromatischer Aberrationen nennen, sondern etwa auch eine automatische Korrektur von Kissen- und Tonnenverzeichnungen, sowie weiteren Abbildungsfehlern. Noch ist das im professionellen Videobereich Zukunftsmusik, aber der erste Schritt ist mit den genannten Techniken schon gemacht.

Ein anderer Trend bei den Objektiven resultiert aus dem Aufkommen der Single-Sensor-Kameras mit großem Bildfenster. Hierfür sind Objektive erforderlich, die dieses große Bildfenster auch vollständig und gleichmäßig ausleuchten. Momentan werden hier überwiegend Festbrennweiten eingesetzt, als Anschlusssystem hat sich der PL-Mount durchgesetzt. Entwicklungen gibt es hier an beiden Enden der Preisskala: Für höchste Ansprüche bietet Leica in Kürze ein Set aus zehn Objektiven in der Größenordung von ungefähr 120.000 Euro Listenpreis an. Ein preisgünstiges Set aus fünf Primes kündigte Schneider Optics für 22.000 US-Dollar an. Andere Anbieter von PL-Festbrennweiten für verschiedene Zielmärkte sind Cooke, Zeiss und Red — in weitgehender Zurückhaltung übt sich bei diesem Thema Canon. An die schwierige Aufgabe, PL-Mount-Zooms für digitale Kameras zu bauen, haben sich Fujinon und Angénieux gewagt. Fujinon baut auch die Alura-Zooms für Arri.

Welcher Codec ist der Beste?

Jeder, der sich wirklich mit Videotechnik beschäftigt, hat sie schon nach kurzer Laufbahn mehrfach gesehen: Eine Vergleichsanordnung mit zwei Monitoren, auf denen das gleiche Bildmaterial zu sehen ist, aber mit unterschiedlichen Kameras und Codecs aufgenommen. Und jedes Mal war ganz klar ersichtlich, dass das Material von Kamera A und Codec X, dem von Kamera B und Codec Y meilenweit überlegen war — abhängig davon, wer den Vergleich durchgeführt und gezeigt hat. Hat man dieses Spiel eine Weile verfolgt, neigen Pragmatiker der Erkenntnis zu, dass offenbar jede Kamera und jeder Codec irgendwo Schwachpunkte haben, die man herausfinden und mit ausgesuchten Aufnahmesituationen zum Nachteil eines anderen und zur eigenen Überhöhung vorführen kann.

Das soll nicht heißen, dass es keine relevanten Unterschiede gäbe und dass es ganz gleichgültig sei, wofür man sich entscheidet. Es soll aber heißen, dass man keinem der Digital-Taliban glauben und folgen sollte, die fanatisch an einer Technologie hängen. Die Zeiten ändern sich, es gibt überaus rasche Entwicklungen und es spielen viele Kriterien eine Rolle. Oder haben Sie Ihr Auto ausschließlich nach dem Drehmoment im vierten Gang ausgesucht?

Es geht also bei der Wahl des richtigen Produktionssystems um mehr als um einen Codec, ein Format, die Quantisierung oder das Sampling: Der ganze Workflow muss stimmen. Eine mögliche Grundlagenfrage: Gibt mir das gewählte System ausreichend Sicherheit und Flexibilität beim Dreh, beim Sichten und in der Nachbearbeitung — und kann ich mir die Folgekosten leisten?

Nach wie vor gilt ein einfacher Grundsatz: Was man ganz am Anfang der Produktionskette an Qualität nicht aufgenommen hat, das kann man später auch nirgends mehr dazu gewinnen. In der Postproduktion kann man nur dafür sorgen, dass das, was man hat, möglichst gut aussieht. Oder in der Kurzform: Junk in, junk out.

Ganz sicher gibt die Datenrate eine erste Orientierung in puncto Qualität, aber in Zeiten ausgefuchster Kodiertechniken geht es auch darum, bei welchem Verfahren die verfügbare Datenrate am effektivsten genutzt wird. Hierüber allgemeingültige Aussagen zu treffen, ist aber sehr schwierig. Zum einen kann es tatsächlich vom einzelnen Motiv abhängen, wie gut ein bestimmtes Kodierverfahren arbeitet, zum anderen geht es hier immer weniger um Messwerte, als um den Bildeindruck, den der menschliche Betrachter gewinnt.

Als grobe Richtschnur und Tendenz kann aber gelten: Ein Signal mit einer Videodatenrate von 200 Mbps und einem Abtastverhältnis von 4:4:4 kann eine höhere Bildqualität aufzeichnen, als eines mit 100 Mbps und 4:2:2, das wiederum mehr Qualität erlaubt als 4:2:0 mit 25 Mbps — aber es kommt eben auch auf den jeweils verwendeten Codec an.

Aus dem Consumer-Bereich kommt mit AVCHD ein Kompressionsverfahren, das sich wachsender Beliebtheit erfreut und auch schon im unteren Profibereich verwendet wird. Es ist rechenintensiv, unter anderem weil es ein Interframe-Verfahren ist, also mehrere aufeinanderfolgende Bilder verwendet, um redundante Daten zu erkennen und wegzulassen. Dieser Nachteil verliert aber mit der ständig wachsenden CPU– und GPU-Leistung in gängigen PCs an Schrecken.

Dort wo AVCHD »viel zu schlecht« ist, also in Richtung oberem Ende der Qualitätsansprüche, waren früher auf der digitalen Akquisitionsseite die Videoformate von Sony und Panasonic unter sich: MPEG– und <LEX>DVC</LEX>-basierte Formate waren die Regel. Seit aber Codec und Speichermedium immer weiter entkoppelt sind, seit file-basiertes Arbeiten immer normaler wird, kommen auch <LEX>ProRes</LEX> von Apple, DNxHD von Avid, Wavelet, JPEG2000 und viele weitere, ebenfalls schon bei der Originalaufnahme zum Einsatz.

Weil aber der Traum vom Camcorder mit frei wählbarem Codec bisher noch nicht in Erfüllung ging, unterliegt man hier in der Praxis doch noch einigen Beschränkungen. Aber die Vielfalt wächst weiter: So entschied sich etwa Arri, bei der Digitalkamera Alexa zunächst bei der Onboard-HD-Aufnahme im ProRes-422-Codec von Apple auf SxS-Medien von Sony zu speichern.

Zusätzliche Erweiterungen der Vielfalt bieten hierbei Dockrecorder, etwa von Aja, Convergent, Keisoku Giken, S.Two, Codex und anderen. Dabei ist es sinnvoll und erstrebenswert, nicht erst im Camcorder ein kodiertes Signal zu erzeugen, das dann vom Recorder wieder dekodiert werden muss, bevor der es aufzeichnen kann. Grenzfälle gibt es aber durchaus: Einige Camcorder erzeugen intern ein besseres Signal, als das integrierte Aufnahmesystem es aufzeichnen kann — etwa dann, wenn der integrierte Codec nur 4:2:0-Aufzeichnung bietet, der Kamerateil des Geräts aber mit 4:2:2 arbeitet und dies auch an der HD-SDI-Buchse abgibt.

Raw-Basics

In einigen Bereichen der Bewegtbildaufnahme setzt sich eine im Grunde noch radikalere Idee durch: Man zeichnet nicht mehr in einem Videoformat und unter Einsatz eines Video-Codecs auf, sondern speichert direkt die digitalen Rohdaten der Kamera — komprimiert oder unkomprimiert.

Der prinzipielle Vorteil liegt darin, dass die Kameraelektronik vereinfacht wird und für die nachträgliche Bildgestaltung mehr Spielraum bleibt. Der Nachteil liegt darin, dass man Raw-Daten bei der Aufnahme nicht so einfach ansehen und in puncto Qualität kontrollieren und überwachen kann — sowie in umständlicherem Handling und komplexeren, zeitaufwändigeren Abläufen in der Postproduktion mit vielen potenziellen Fehlerquellen. Hier hat sich aber im vergangenen Jahr mit neuen Hard- und Software-Lösungen, sowie mit einer gewissen Standardisierung, vieles zum Positiven gewendet: Es ist immer noch aufwändiger, mit Raw-Daten zu arbeiten, als mit Videodaten, aber es ist einfacher geworden und es gibt Lösungen für direktes Playback und einfacheren Import von Raw-Daten in der Postproduktion.

Das Raw-Grundprinzip sieht so aus: Alle gängigen Bewegtbildsensoren erzeugen zunächst nur Schwarzweißbilder. Die Farbinformation wird erst durch verschiedene Filterverfahren gewonnen. Eines davon, das überwiegend bei Single-Sensor-Kameras angewendet wird, ist das nach seinem Erfinder benannte Bayering: Dabei wird den einzelnen lichtempfindlichen Bildpunkten auf dem Sensor ein festgelegtes Muster zugeordnet, das Bayer-Pattern. Die Hersteller können dabei relativ frei schalten und walten, wie sie Rot-, Grün- und Blauanteile aus dem auf den Sensor fallenden Licht filtern wollen.

Die Daten, die man mit einem solchen Sensor gewinnt, werden Raw-Daten genannt. Um aus diesen Daten ein korrektes Farbbild darstellen zu können, muss man bei der weiteren Bearbeitung das Muster kennen, das den Bildpunkten zugeordnet wurde und man muss wissen, wie die Daten zu gewichten sind. Das wird beim De-Bayering umgesetzt und ist eine Wissenschaft für sich: Der hierbei verwendete Algorithmus entscheidet über die Bildqualität mit, besonders was die Auflösung, die Schärfe, die Farbwiedergabe und die Kantendarstellung betrifft.

Das De-Bayering kann man direkt in der Kamera durchführen und dann ein aus den Raw-Daten gewonnenes Videosignal aufzeichnen. Alternativ dazu kann man eben die Raw-Daten speichern und das De-Bayering später, also in der Postproduktion durchführen.

Speichermedien

Bei den Speichermedien wächst die Vielfalt weiter und ganz allmählich bröckeln auch die Fronten der Hersteller. Bei den Speicherkarten setzt sich die Entwicklung von fallenden Preisen bei steigender Kapazität weiter fort. Zusätzlich haben Sony bei SxS, Panasonic bei P2 und Ikegami bei den GF-Paks, jeweils neue, preisgünstigere Serien eingeführt, die alternativ angeboten werden.

Zu Kassettenzeiten waren Speichermedium und Codec noch eng verknüpft, man sprach von »Formaten«. Das lockerte sich etwas auf, als es mit dem Aufkommen der zweiten Welle digitaler Videoformate möglich wurde, auf der gleichen Kassette unterschiedliche Signale zu speichern. Mittlerweile trennen sich Speichermedium und Codec immer weiter und die Videohersteller müssen der Situation ins Auge blicken, dass sie hier die Hoheit verloren haben: File-basiertes Videomaterial lässt sich eben auch auf Festplatten, Speicherkarten und Sticks ablegen, die der Camcorder-Hersteller nicht selbst im Angebot hat. Was allerdings an den meisten Camcordern fehlt, ist eine Möglichkeit, tatsächlich file-basierte Signale im laufenden Betrieb auf externe Medien zu speichern: Entweder gibt es keine Schnittstelle mit ausreichender Transferrate, oder es werden einfach keine Live-Daten darüber bereitgestellt.

Als internes Speichermedium bei Camcordern weiterhin auf dem Vormarsch: SDHC-Speicherkarten. Sony etwa hatte sich noch lange gegen die SD-Speicherkarten gestemmt und erfolglos den eigenen Memory Stick in der Variante Pro Duo dagegen gesetzt. Seit kurzem ermöglicht es der Hersteller aber, SDHC-Speicherkarten bei seinen AVCHD-Geräten zu verwenden: direkt, ohne Adapter. Auch bei SxS-Speicherkarten weicht Sony seine harte Haltung zunehmend auf und bietet nun selbst einen SDHC-auf-SxS-Adapter an — wie ihn bisher nur Drittanbieter offerierten.

Einen SDHC-auf-GF-Adapter will künftig auch Ikegami anbieten, um den Käufern seiner GF-Cam ebenfalls die Nutzung der relativ preisgünstigen SDHC-Speicherkarten zu ermöglichen.

Mit dem Argument, dass man bei P2-Geräten Datenraten bis zu 100 Mbps schreiben müsse, weigert sich Panasonic bisher noch eisern, die Schranken zwischen P2 und SDHC fallen zu lassen und es gibt hier auch keine Lösungen von Drittanbietern. Dabei sind P2- und SD-Karten eng verwandt: Im Herzen der P2-Karten werkeln vier von einem gemeinsamen Controller gesteuerte SD-Speicherchips.

Die Grenze zwischen P2 und SD-Speicherkarten könnte aber im nächsten Schritt der SD-Karten-Entwicklung fallen: SDXC steht für »SD Extended Capacity« und ist die nächste Stufe nach dem aktuellen SDHC-Standard. SDXC-Speicherkarten und -Lesegeräte sollen Schreib-/Lesegeschwindigkeiten von bis zu 300 Megabyte pro Sekunde (MBps) bieten und noch höhere Speicherkapazitäten erreichen, als sie heute bei P2 verfügbar sind. Mit den Eckdaten von SDXC gibt es dann eigentlich keine Notwendigkeit mehr, vier SD-Speicherkarten in einer P2-Karte zu kombinieren — aber es spricht natürlich auch nichts dagegen, das weiterhin zu tun: Panasonic könnte zukünftig auf Basis von SDXC-Komponenten P2-Speicherkarten mit so hoher Kapazität und Datenrate herstellen, dass Geräte mit nur einem Kartenslot gebaut werden können, die zudem auch unkomprimierte HD-Aufzeichnung ermöglichen.

Dass Bewegung im Markt ist, zeigt auch Arris Digitalkamera Alexa: Die nutzt SxS als Onboard-Aufzeichnungsmedium, ist aber laut Hersteller so ausgelegt, dass man durch den Austausch weniger Teile prinzipiell auch andere Speichermedien verwenden könnte.

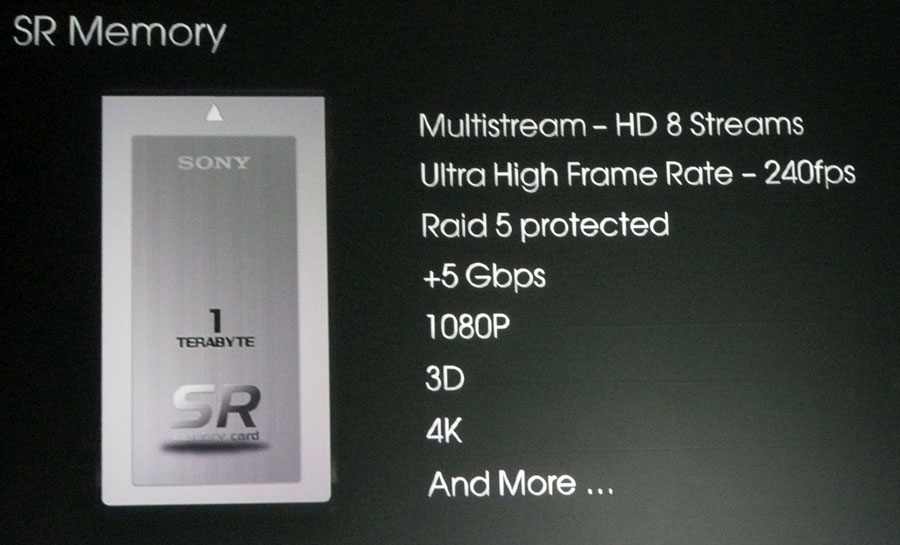

Eine Lücke klafft derzeit noch bei der kompakten, bandlosen Speicherung von Daten im High-End-Bereich. Dass weder das Arbeiten mit ganzen Stapeln von Festplatten, noch der Einsatz von HDCAM SR, der Weisheit letzter Schluss sein kann, das ist schon längst klar. Deshalb hat etwa Sony für 2011 die Einführung eines Festspeichersystems angekündigt, das eine Speicherkapazität von einem Terabyte und Transferraten von 5 Gbps bieten soll. SR-Memory soll als alternatives Speichermedium für den Camcorder SRW-9000 und die Kameras F35 und F23 angeboten werden. Bis dahin setzt Sony am Top-End weiterhin auf Band als Speichermedium — und lässt damit Raum für die schon genannten Recording-Systeme von Aja, Convergent, Keisoku Giken, S.Two, Codex und anderen.

Sicher ist am High-End die Standardisierung nicht so wichtig, wie etwa im breiteren TV-Produktionsbereich, schließlich wird hier schon immer mit Sonderlösungen und Spezialapparaturen gearbeitet. Aber schöner und praktischer wäre es schon, wenn es auch hier so etwas wie eine Standardlösung in puncto Dateiformaten, Codecs und Speichermedien gäbe.

Fazit

Der Wunsch nach schnelleren, effektiveren Arbeitsmethoden ist heute eher die Regel als die Ausnahme. Wie ärgerlich also, wenn beim Dreh Zeit und Geld gespart wurden, die dann durch vermeidbare Zwischenschritte in der Postproduktion wieder verloren gehen. Deshalb sollte man stets den ganzen Ablauf von der Aufnahme bis zum fertigen Produkt im Auge haben, um die jeweils passende Entscheidung zu fällen.

Stereo-3D steht noch am Anfang, hat aber das Potenzial, sich rasch durchzusetzen. Wer jetzt schon investiert, sollte darauf achten, dass sich das Equipment sehr zügig amortisieren sollte: Wenn Stereo-3D abhebt, wird es hier sehr schnell Verbesserungen geben, die bestehendes Equipment alt aussehen lassen.

Sollte man mit aktuellen Investitionen nicht generell warten, wenn so viele technische Veränderungen unmittelbar vor der Tür stehen? Nein — denn das wird sich nicht mehr ändern: Die Technik ist heute auch im Profi-Videobereich einfach schnelllebiger und es werden ständig irgendwelche Neuerungen angeblich unmittelbar bevorstehen — und dann entweder sehr schnell kommen, oder doch noch ewig auf sich warten lassen. Irgendwann muss man sich also entscheiden und damit der Gefahr aussetzen, genau zum falschen Zeitpunkt zu investieren. Wenn man das zu lange unterlässt, wird man einfach abgehängt.

Dabei im Hinterkopf zu behalten, dass Produktzyklen immer kürzer werden und Trends schneller wechseln, kann sicher nicht schaden: Die Zeit, die bleibt, um Equipment in die Gewinnzone zu bringen, wird sich weiterhin verkürzen. Ausnahmen davon gibt es: Für einen Satz hochwertiger PL-Mount-Objektive wird es voraussichtlich noch länger Verwendung geben.

Weitere Infos

Einen umfasssenden Formatreport aus dem Jahr 2009 finden Sie hier. Einige der allerjüngsten Formate sind darin noch nicht enthalten, aber der Report gibt einen recht umfangreichen Überblick zu diesem verwandten Thema. Technische und praktische Hintergründe zum Thema »720p vs. 1080i« finden Sie hier.