Studentenprojekt »Stichprobe«: Stop-Motion-Film mit 3D-Charakteren

Einer besonderen Herausforderung in gestalterischer wie technischer Sicht, stellten sich Studenten der Hochschule der Medien in Stuttgart (HdM) mit ihrem Kurzfilmprojekt »Stichprobe«: Sie kombinierten Stop-Motion-Realaufnahmen mit computer-generierten 3D-Charakteren. Herausgekommen ist ein witziger und ästhetisch beeindruckender Animationsfilm. Gregor Baumert, Student der Audiovisuellen Medien, berichtet über das Projekt.

An der HdM entstand im Sommer 2008 im Rahmen der Lehrveranstaltung »Studioproduktion Interaktive Medien und Computer Animation« mit dem Stop-Motion-Film »Stichprobe« ein ambitioniertes Projekt: Die Kombination von Stop-Motion-Aufnahmen mit im 3D-Animationsprogramm Maya modellierten Charakteren. Mit einer

Ein Blick zwischen die Teppichhalme von »Stichprobe«

Aus »Die Teppichvölker« von Terry Pratchett: »Am Anfang gab es nur eine unendliche Ebene. Dann kam der Teppich und bedeckte die grenzenlose Flachheit. Damals war er noch jung. Es fehlte Staub zwischen seinen Haaren, die heute krumm und schmutzverkrustet sind — damals ragten sie glatt und gerade auf. Und zu jener Zeit war der Teppich leer.«

Ähnlich erging es uns zwölf Studenten, als wir begannen, den Film »Stichprobe« zu entwickeln. Wie baut man einen Teppich, der in Stop-Motion-Technik animiert werden kann und sich zudem mit normalen Fotooptiken in Szene setzen lässt, aber überdimensional groß wirkt? Hinzu kamen unsere beiden Protagonisten: Milbert, die Milbe und Erisch, die Schnake: Zeit zum Puppenbau, dazu noch in verschiedenen Maßstäben, hatten wir nicht. Das Erstellen der Charaktere am Computer war also auch aus zeitlichen Gründen notwendig.

Inspiration war für uns hierbei auch die Serie »Minuscule«, denn dort ist das Zusammenspiel zwischen realem und virtuellem Bild meisterhaft umgesetzt. Nachdem wir uns eine Geschichte rund um die Teppichwelt überlegt hatten, konnten wir dazu übergehen, uns diesen Mikrokomos zu erschaffen.

Der Urknall – Setbau

Erste Erkundungstouren in zahlreichen Baumärkten der Umgebung brachten schließlich einen brauchbaren Teppich für die Aufnahmen der Flugszenen im Zimmer mit der Schnake Erisch hervor. Schnell war jedoch klar, dass für die »Makroaufnahmen« mit der Milbe Milbert zwischen den Teppichfasern ein spezielles Set gebaut werden musste. Somit begann die lange Phase des Testens und Experimentierens. Was dann kam, erinnerte an Basteln im Kindergarten: Nachdem 12 kg Filz in tagelanger Fleißarbeit zu Würsten geformt, jedes Haar mit speziellem Aluminiumdraht versehen und das ganze auf eine alte Holzschublade montiert war, wurde langsam aber sicher ein überdimensionaler orange-brauner Teppich erkennbar. Dieser rund einen Quadratmeter große Teppich sah allerdings noch recht »fabrikneu« aus. Durch Flechten vom Campuspflaster, Staubflusen vom Studioboden, Kohlestaub vom Grill, ein paar Kleckse Farbe und einigen aus Fimo geformten Pflanzen bekam er schließlich seinen endgültigen Charakter. Das Problem, dass der gekaufte Baumarkt-Teppich für die Totalen der Zimmeraufnahmen jedoch weiß war, ließ sich mittels zahlloser Liter gespendeter Textilfarbe nachträglich lösen.

Wie die Bilder laufen lernten – Die Wahl der Kamera

Die Wahl der Kamera fiel auf die Canon EOS1DS Mark II, da wegen des Vollformatsensors die Schärfentiefe filmähnlicher ist und besser gesteuert werden kann. Außerdem erschien uns bei dieser Kamera der Übergang von Schärfe zu Unschärfe nicht so hart wie bei anderen Modellen. Das nächste Problem stellten jedoch die heutigen Objektive dar, bei denen meist der manuelle Blendenring fehlt. Nach einem Test mit verschiedenen Objektiven und Kameras war schnell klar, dass die Ringblenden der Fotoobjektive zu einem Helligkeitsflackern führten. Dies liegt wohl daran, dass diese Ringblenden nicht absolut präzise arbeiten. Da unsere Arbeitsblende meist bei f/16 lag, wäre das Flackern ziemlich extrem ausgefallen und ein Herausrechnen kam aus zeitlichen Gründen nicht in Frage — schließlich standen für das gesamte Projekt nur vier Monate zur Verfügung.

Dank eines Adapters konnten wir auf alte Nikkor-Objektive mit manuellem Blendenring zurückgreifen. Die Brennweiten von 35 mm und 50 mm waren allerdings meist viel zu weitwinklig. Unser Hauptobjektiv wurde deshalb ein altes Nikon-Zoomobjektiv, das wir meistens bei 110 mm Brennweite benutzten. Manche Einstellung wurde in Photoshop bis auf Briefmarkengröße beschnitten, um den gewünschten Bildausschnitt zu erhalten. Dies machte dann auch die Arbeitsblende f/16 notwendig. Somit war auch in diesen Makroeinstellungen noch ein gewisser Bereich im Bild für das Auge als scharf wahrnehmbar.

Bei Stop-Motion Filmen ist man nicht an die übliche 1/50 s Belichtungszeit gebunden. Die sehr große Arbeitsblende machte somit keinen übermäßigen Lichteinsatz notwendig. Allerdings arbeiteten wir dadurch meistens mit Belichtungszeiten zwischen einer und zwei Sekunden. Insgesamt kamen wir mit sechs 150-W-Dedolights und zwei fest installierten, über dem Set hängenden, 2-kW-Scheinwerfern aus.

Das vom Motion-Control-Computer gesteuerte Licht-Rig mit den beiden 2-kW-Scheinwerfern sorgte durch einen mit Frost bestückten Rahmen, der zwischen Set und Scheinwerfern hing, für eine Grundhelligkeit im »Teppichwald«. Die Dedolights waren mit Black-Wrap bestückt und standen hinter dem eigentlichen Teppichaufbau. Somit konnten durch Löcher im Black-Wrap zielgenau harte Lichtflecken am Teppichboden und Kanten an den Teppichhaaren erzielt werden. Als Vorlage für die verwendete Ausleuchtung diente die Lichtstimmung in einem dichten Laubwald an einem wolkenlosen Sommertag. Das Scharfstellen wurde aufgrund der Kamerafahrten, dem oftmals etwas ungenauen Schärfering der Objektive und dem Fehlen einer Live-View-Funktion an der Kamera zu einer Versuch- und Irrtum-Orgie. Als bester Weg stellte es sich heraus, ein Foto zu machen, dieses am Rechner in einer 100-Prozent-Ansicht auf die Schärfenlage zu überprüfen und solange am Schärfering zu drehen, bis man mit dem Resultat zufrieden war. Danach galt, was bei Stop-Trick generell gilt: bloß nichts unkontrolliert bewegen und sich ganz langsam und bewusst bewegen.

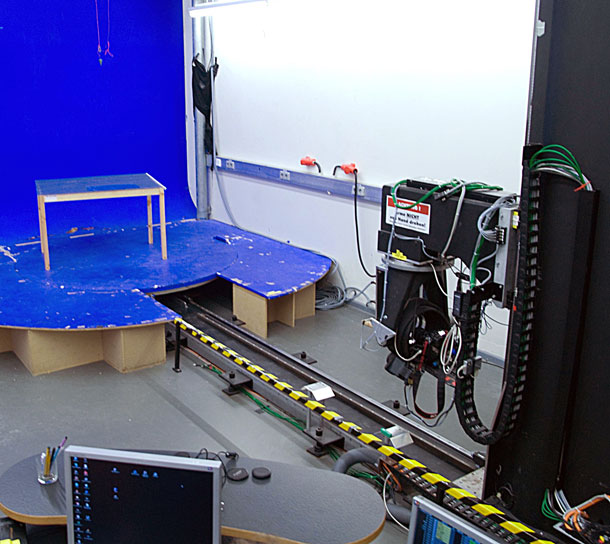

Motion Control — Studiodreh

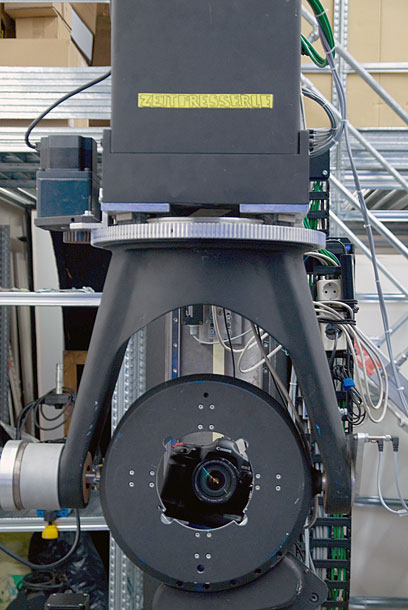

Es konnte also losgehen mit weiteren Tests. Das Motion Control-System der Hochschule der Medien besteht im Wesentlichen aus den handelsüblichen Komponenten eines Industrieroboters. Es entstand im Rahmen einer Abschlussarbeit zweier Studenten der Audiovisuellen Medien und fand bisher hauptsächlich Verwendung für Stop-Trick-Filme. Das System lässt sich aber auch für 360-Grad-Produktpräsentationen oder ähnliches verwenden.

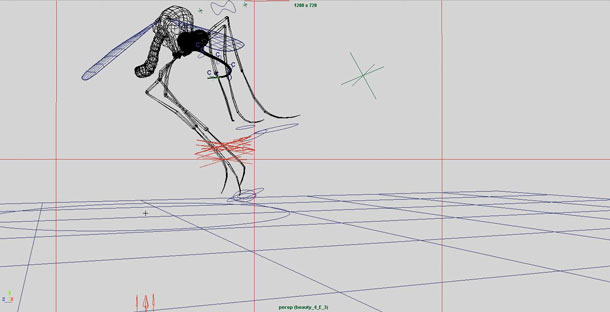

Beim Drehen mit dem Motion-Control-System der HdM ist nach der Aufnahme kein rechenintensives Tracking nötig, da die Fahrt direkt im 3D-Programm Maya erstellt werden kann und man die Bewegungsdaten der Kamera für das Compositing somit noch vor der eigentlichen Aufnahme zur Verfügung hat.

Das System wird über die oscar-prämierte Motion-Control-Software Kuper-Control gesteuert. Die Software, die zu Zeiten von MS-DOS stehen geblieben ist, hat den Vorteil, dass die Kommunikation über die spezielle Kuper-Steckkarte im Rechner ohne Zeitverzögerung umgesetzt wird. Auch die etwas benutzerunfreundliche Bedienoberfläche wird nach einigen Tagen durchschau- und benutzbar.

Der Roboter — von uns liebevoll »Zeitfresserle« getauft — verfügt über fünf getrennt ansteuerbare Achsen. Dank einer am Boden verankerten Schiene lassen sich bis zu fünf Meter weite Zu- oder Wegfahrten über die Trackachse realisieren. Die Liftachse ermöglicht es, gute zwei Meter in der Höhe zu fahren. Der eigentliche Kamerakopf erlaubt neben dem üblichen Pan (Schwenken) und Tilt (Neigen) auch das Drehen um 360 Grad. Hinzu kommen noch eine Drehscheibe als eigentliches Set von zwei Meter Durchmesser und das bereits erwähnte Licht-Rig.

Dank eines an der Hochschule entwickelten Maya-Plug-Ins lassen sich durch die Kombination der Drehscheibe mit Pan und Track sogar Parallelfahrten realisieren. Wenn man eine Fahrt in Maya generiert hat, wird diese per Diskette in den Kontroll-Computer geladen. Da die Fahrt in Maya bereits auf eine bestimmte Frame-Zahl ausgelegt wurde, fährt der Roboter nun jedes Mal, nachdem die Kamera ausgelöst wurde und das Bild per

Nachdem sich der bisher von Studenten für andere Puppenfilme entwickelte Workflow als zu langsam und ungeeignet für unsere Zwecke herausstellte, gingen wir dazu über, das System um ein paar eigene Skripte zu erweitern und die Kamera mit einem »Fußauslöser« zu versehen. Dieser Schalter ermöglichte es dem Animator, die Kamera nach jedem Animationsschritt auszulösen.

Dank unserer Skripte wurden aus den aufgenommen Raw-Daten direkt JPEG-Previews generiert und das Motion-Control-System konnte Fahrten vollautomatisch durchführen. Bei der Parallelfahrt waren immerhin 500 Bilder nötig. Alleine durch die Belichtungszeit von zwei Sekunden dauerte es somit eine ganze Weile, bis diese Einstellung im Kasten war. Hinzu kam, dass die Fahrt noch zweimal wiederholt werden musste, damit für das Compositing eine Travelling-Matte aufgenommen werden konnte. Beim zweiten Durchgang wurden die Teppichhalme mit einem Greenscreen für das Keying hinterlegt, um sich das nachträgliche Rotoscoping der Milbe sparen zu können. Für diesen Shot brauchten wir dann auch zwei ganze Drehtage und Nächte. Stop-Motion ist eben eine langwierige und zeitintensive Sache, selbst wenn man sich das Animieren der Charaktere erspart.

Leben im Teppich – Dreh on Location

Nachdem wir im Studio die Aufnahmen des überdimensionalen Teppichs abgeschlossen hatten, drehten wir im Zimmer eines Kommilitonen mit einem alten Stuhl vom Sperrmüll den Auftritt der Schnake Erisch. Hierbei setzten wir komplett auf das natürliche Licht. Da wir die Fernbedienung und das Buch im Zimmer als reale Objekte zur Verfügung hatten, erstellten wir mittels einer Silberkugel direkt noch ein paar HDRI-Panoramen des Raums. Somit konnten wir später im Compositing den Raum in Erischs Augen mittels Image Based Lighting einspiegeln lassen. Im Studio bauten wir die Lichtstimmung für den Flug und die näheren Einstellungen des Teppichs nach. Dabei kam ein 4-kW-

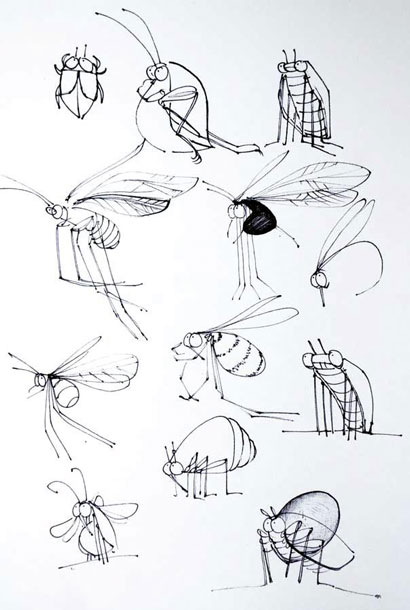

Leben entsteht – Charakterdesign und Computeranimation

Die Computeranimation begann zunächst mit der Diskussion, für welches HD-Endformat wir uns entscheiden sollen:

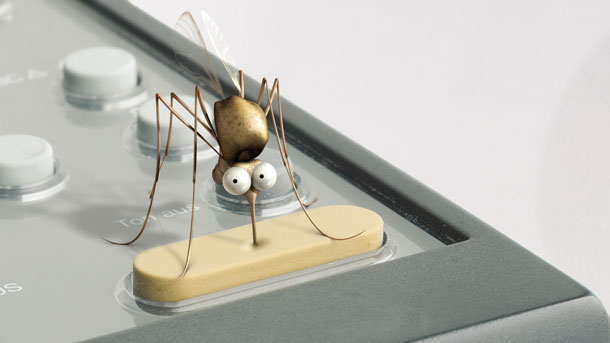

Der Entwurf auf Papier wurde dann am Computer modelliert. Eigentlich unterscheidet sich dieser Prozess nicht vom modellieren mit Ton. Anstatt eines Lehmklumpens verwendet man allerdings Polygone und eine Maus anstatt der Töpferwerkzeuge. Weil den Augen eine besondere Bedeutung als Mittel zum Erzeugen von Gefühlen und Emotionen bei animierten Charakteren zukommt, bekamen die weitgehend realistisch aussehenden Protagonisten individuelle und charakteristische Augen. Die Milbe Milbert lernte dank eines vorgefertigten Laufmodells das Tippeln. Erischs Flugkünste mussten hingegen von Hand animiert werden, was einige Zeit in Anspruch nahm.

Für die Texturen ging es auf Bildersuche ins Internet und in diverse Naturführer. Eine Walnuss diente letztlich als Textur für Erischs Körper. Milbert wurde mehrmals »umlackiert«, bis wir uns schließlich für die blaue Farbe entschieden, die sich gut vom orangen Teppich abhebt. Die Struktur seiner Hautoberfläche schauten wir uns bei einem Elefanten ab. Die Textur des Brotkrümels hingegen war schwieriger zu erstellen. Schließlich sollte der Krümel ansprechend und realistisch aussehen.

Das Licht im 3D-Raum wurde — gemäß dem am realen Set verwendeten Lichtaufbau — in Maya nachgebaut. Eine große Hilfe war hierbei allerdings die Verwendung von »negativem Licht« im 3D-Programm. Was sich wahrscheinlich jeder Beleuchter in der Realität wünscht, aber umständlich mit Abdeckfahnen und Black-Wrap herbeiführen muss, lässt sich dadurch am Computer recht einfach erzeugen. Für die Lichtstimmung im Teppich und einen zwischen Halmen hin und herlaufenden Milbert war dies eine große Erleichterung.

Die Kommunikation lief während der gesamten Projektphase recht leger aber dennoch konzentriert ab. So manche Entscheidung bezüglich des weiteren Vorgehens wurde mit einem Eis in der Hand in der Sonne entschieden: Keine Selbstverständlichkeit bei zwölf Leuten im Team und mit Vorlesungen, die teilweise noch parallel besucht werden mussten. Vier Leute, die im Computeranimationslabor arbeiteten, hatten über den Server ständig Zugriff auf die im Motion Control gedrehten Bilder. Unser Skript erstellte direkt eine JPEG-Datei mit stark reduzierter Auflösung, die schon auf die endgültige Größe beschnitten war. Um zum Beispiel Erischs Flug um den Stuhl zu animieren und zu beleuchten, reichte diese geringe Auflösung als Vorlage vollkommen aus. Erst im Compositing kamen dann die fertigen Bilder aus der realen und der virtuellen Welt zusammen.

Zwei Welten prallen aufeinander – Das Compositing

Die gesamte Manpower verbrachte schließlich zwei Sommermonate am Computer. Neben dem Rendern der computeranimierten Daten, galt es, den aufgenommenen Fotos einen spezifischen Look zu verpassen. Dabei kam die Adobe-Software Lightroom zum Einsatz, mit der sich die Raw-Daten schnell und effizient bearbeiten ließen. Der erste Schritt war das Beseitigen von eventuell vorhandenen Fusseln im Bild. Als nächstes wurde dann die Farbkorrektur für die Shots angewandt und das Bild als 8-Bit-Tiff ausgespielt. Abschließend wurde der schon bei der Aufnahme festgelegte Beschnitt, also die endgültige Cadrage, in Photoshop per Stapelverarbeitung auf die Bilder angewendet.

Das war wichtig, da die Previews, auf die die Animationen ja ausgelegt waren, wieder mit dem fertigen Bild übereinstimmen mussten. So wurden die einzelnen Shots nach und nach mit der Compositing-Software Fusion zusammengefügt. Aus Maya kamen dazu pro 3D-Charakter verschiedene Ebenen wie etwa Beauty, Motion-Vector, Schatten und Occlusion, deren Parameter auch nachträglich noch im Compositing in Fusion je nach Bedarf geändert werden konnten. Der Motion-Vector war vor allem für Erischs wildes Flügelschlagen wichtig, um die Bewegungsunschärfe natürlich darstellen zu können. Zudem wurde mittels eines Depth Path die passende Tiefenschärfe für die computergenerierten Daten herausgerechnet.

Als schwierig erwies sich teilweise das Freistellen der Halme. Die beste Methode war hierbei, die feinen Filzhaare »wegzukeyen« und danach einfach wieder von Hand aufzumalen. Zudem waren die verwendeten Farbtafeln für das Keying im Teppich nicht gleichmäßig auszuleuchten. Bei der langen Parallelfahrt durch den Teppich kamen wir also nicht umhin, große Teile zu rotoskopieren. Beim Zusammenfügen der Bilder wurde dann noch eine letzte Farbkorrektur realisiert, damit der Teppich und die Charaktere auch beim nächsten Schnitt noch zusammenpassten. Geschnitten wurde das gesamte Projekt mit Final Cut Pro. Dazu wurden die von Fusion generierten Tiff-Dateien mittels Quicktime Pro zu einer Bildsequenz zusammengefügt und als unkomprimierte Mov-Datei gespeichert. Beim Schnitt konnte somit immer mit dem aktuellsten Stand der Computeranimation und des Compositings gearbeitet werden. Am Ende wäre uns dieses Konzept allerdings fast zum Verhängnis geworden: Da alle Daten auf einem Server im Hochschulnetzwerk lagen und in der Nacht vor unserem Kolloquium — also der Benotung durch unsere Professoren — das Netzwerk an seine Grenzen stieß, hätte das Berechnen des fertigen Films drei Tage dauern sollen. Abhilfe brachte eine externe Festplatte, auf die alle Projektdaten kopiert wurden. Das Rendern von Festplatte ging dann recht flott.

Eine Parallelwelt – Das Sounddesign

Während der Postproduktionsphase durchstreiften drei Leute diverse Soundbibliotheken auf der Suche nach passenden Soundeffekten. Der beim Bau des Teppichs verwendete Akkuschrauber kam im Tonstudio als Tonquelle noch einmal zum Einsatz, eine alte Apple-Tastatur diente als Eingabegerät für Milberts Laufgeräusche. Die Zimmer-Atmo würde an einem Sonntagmorgen in einem Hinterhof in Stuttgart-West aufgenommen. Milberts »mümmeln« wurde mittels Voice-Acting eines Teammitglieds erzeugt. Ein befreundeter Pianist improvisierte im hochschuleigenen Tonstudio kurzerhand die Filmmusik. So kam ein einzigartiger Soundmix zusammen, der den visuellen Charme des Filmes noch unterstreicht.

Die vier Monate dauernde Expedition in die Tiefen des Teppichwaldes, mit all ihren gestalterischen Herausforderungen und technischen Tücken endete in einem Kurzfilm, der aus technischer Sicht einiges zu bieten hat. Es war uns jede arbeitsaufwendige Minute im dunklen Motion-Control-Studio und vor den Computerbildschirmen wert — trotz Badewetter.

Aus »Die Teppichvölker« von Terry Pratchett: »Voller Leben steckte der Teppich, aber er wusste nichts von seiner Lebendigkeit. Er konnte sein, aber er konnte nicht denken. Er hatte überhaupt keine Ahnung von der eigenen Existenz.«

Kontakt zum Verfasser:

Gregor Baumert: gb013@hdm-stuttgart.de