Generatives Erweitern in Premiere Pro Beta

Die Beta-Version von Premiere Pro bietet eine Funktion, mit der sich Szenen per KI verlängern lassen. film-tv-video.de hat sie ausprobiert.

In den vergangenen Monaten sind besonders viele KI-Entwicklungen auf uns eingeprasselt. Sehen wir uns an, was Adobe entwickelt hat.

Der US-Hersteller hat bei seinen KI-Entwicklungen immer betont, dass es bei KI darum gehen sollte, Werkzeuge zu schaffen, die im Editing helfen, die Arbeit abnehmen oder Probleme lösen. Diese Strategie scheint Adobe auch bei der neuen Funktion »Generatives Erweitern« zu verfolgen. Sie soll nicht völlig neue Inhalte auf der Basis von Textprompts liefern, sondern vorhandenes Material bei Bedarf erweitern. Zum Beispiel, wenn eine Szene etwas zu kurz ist oder bei einer Überblendung noch etwas »Fleisch« fehlt.

Testaufnahmen der KI-Verlängerung in Premiere Pro.

Generatives Erweitern kann also perspektivisch eine sehr nützliche Funktion werden – und ist es in einigen Bereichen vielleicht auch schon. Genau das wollte film-tv-video.de herausfinden: Wie gut lässt sich »Generatives Erweitern« im Schnitt einsetzen, wie schlägt sich die KI im Schnittalltag?

Wichtig: Eine Beta-Version ist natürlich Work-in-Progress, erst eine finale Version ist wirklich testfähig. Das muss man beim Lesen bedenken. Unser Ziel war es, einen ersten Eindruck zu gewinnen.

Was aktuell geht

In der Beta-Version von Premiere Pro (Stand November 2024) lässt sich ein Video um bis zu zwei Sekunden verlängern, bei Audio sind es schon 10 Sekunden.

Derzeit kann man Videos in HD für diese Funktion nutzen, mit Frameraten von bis zu 30P.

Möchte man eine Zeitlupe verlängern, geht das derzeit nur mit einem Workaround: Man exportiert zum Beispiel ein 100P Video in 25P, importiert es wieder und kann es dann mit der KI verlängern.

Die Footage in Premiere Pro direkt als 25P zu interpretieren und dann zu verlängern funktioniert aktuell noch nicht. Zudem sollte das Material aktuell auch in Rec709 vorliegen – und nicht etwa in HDR.

Wichtig zu wissen: Generative KI in Premiere Pro ist ein Cloud-Feature, man benötigt also eine Verbindung zum Internet, wenn man es nutzt.

| Keine Kurz-News mehr verpassen und einfach den Newsletter abonnieren: |

Anwendungsfälle für »generatives Erweitern«

Es gibt natürlich viele Möglichkeiten, diese Funktion einzusetzen, hier einige, die sich jede_r schon mal gewünscht haben dürfte:

• Ich möchte eine_n Interviewpartner_in nach einem Statement noch länger im Bild stehen lassen – weil ich beispielsweise die Kamera zu früh ausgestellt habe.

• Ich muss eine Szene verlängern, weil der Schnitt sonst nicht auf die Musik passt.

• Für eine Überblendung brauche ich noch etwas Futter (Spoiler: In diesem Fall funktioniert das »Generative Erweitern« aktuell am besten)

• Eine Person läuft zur Seite aus dem Bild, ich möchte sie aber noch weiter geradeaus laufen lassen (Hier kann man auch mitten im Clip schneiden und per KI weiteren Inhalt nach dem Schnitt generieren).

So funktioniert’s

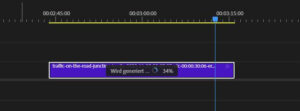

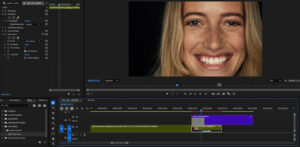

Über das »Generatives Erweitern«-Werkzeug zieht man das Video einfach in die gewünschte Richtung. Premiere generiert dann einen verschachtelten Clip. Klickt man doppelt auf diesen, gelangt man zu einer Timeline, in der das originale Video sowie in einer zweiten Spur das neu generierte Video liegt.

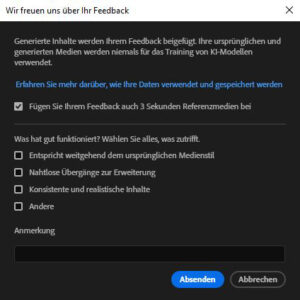

In der Haupt-Timeline befindet dann über dem generierten Teil des Videos ein Balken, über den man per Rechtsklick das Video bei Bedarf neu generieren oder ein Feedback an Adobe senden kann: War das Generieren gut oder schlecht? Was kann die KI besser machen? Aber Vorsicht, dazu muss man sein Video an Adobe senden. Die generierten Versionen werden in einem separaten Ordner abgelegt, somit kann man immer zu vorherigen Versionen zurückkehren oder diese ggf. kombinieren. Das Generieren an sich geht erstaunlich schnell.

Unser Testlaptop hatte folgende Daten:

Intel(R) Core(TM) i9-9900K CPU @ 3.60GHz, 64GB Ram, Nvidia GeForce RTX 2080.

Zwei Sekunden generieren von Video hat 1:33 min gedauert, bei Audio schaffte es die KI in 24 Sekunden.

Beim gleichzeitigen Verlängern von fünf Videos erschien die Meldung »Die KI ist an ihre Grenzen gestoßen, versuchen Sie es später nochmal.«

Apropos Grenzen: Beim Verlängern von Audiomaterial ist man etwas beschränkt, denn Musik übernimmt die KI gar nicht, auch reines Gespräch wird nicht verlängert. Handelt es sich um Atmo, Audioeffekte und Gemurmel im Hintergrund, funktioniert es aber.

KI in Premiere Pro: Status QuoKI hilft beim Schnitt mit Premiere Pro schon aktuell in diversen Bereichen weiter. Ein kurzer Überblick: Beim KI-Farbabgleich werden Szenen in Helligkeit, Kontrast und Farbe aufeinander abgestimmt. Für schnelle Korrekturen liefert diese Funktion ordentliche Ergebnisse. Mit Remix schneidet die KI Videos passend zum Soundtrack. Das funktioniert gut, allerdings wirken auf Beat geschnittene Videos etwas langweilig. Man sollte aber ohnehin immer dann schneiden, wenn es passt, und nicht dann, wenn es der Takt vorgibt. Diese Fähigkeiten kann eine KI ohne »Lebenserfahrung« (noch) nicht. Remix ist also in bestimmten Fällen sehr hilfreich, aber keine Allgemeinlösung. Das automatische Ducking, also das Herunterfahren der Musik bei Dialogen, ist eine sehr hilfreiche Funktion und erspart eine Menge Keyframing. Beim Auto Reframing analysiert die KI wichtige Bildinhalte wie z.B. Menschen und hält diese bei einem Wandel von 16:9- in 9:16-Videos oder auch anderen Seitenverhältnissen im Mittelpunkt des Bildes. Weiterhin sind Audio Tagging (das Zuordnen von Audioinhalten in z.B. Sprache, Musik oder SFX/Special Effects), Sprache-zu-Text (für die Erstellung von Untertiteln) und Sprachverbesserung bereits jetzt in den aktuellen Versionen von Premiere zu finden. Ganz generell gilt: Adobe Firefly, die generative KI von Adobe, wird laut Hersteller ausschließlich mit Content trainiert, für dessen Verwendung der Hersteller die Erlaubnis hat. Adobe Firefly wird also anhand eines Datensatzes von lizenziertem Content trainiert, etwa von Adobe Stock. Hinzu kommen gemeinfreie Inhalte, die nicht mehr urheberrechtlich geschützt sind. |

Seite 1: Einsatzbereiche, Funktionsprinzip

Seite 2: Beispiele und Fazit